Tecnologia

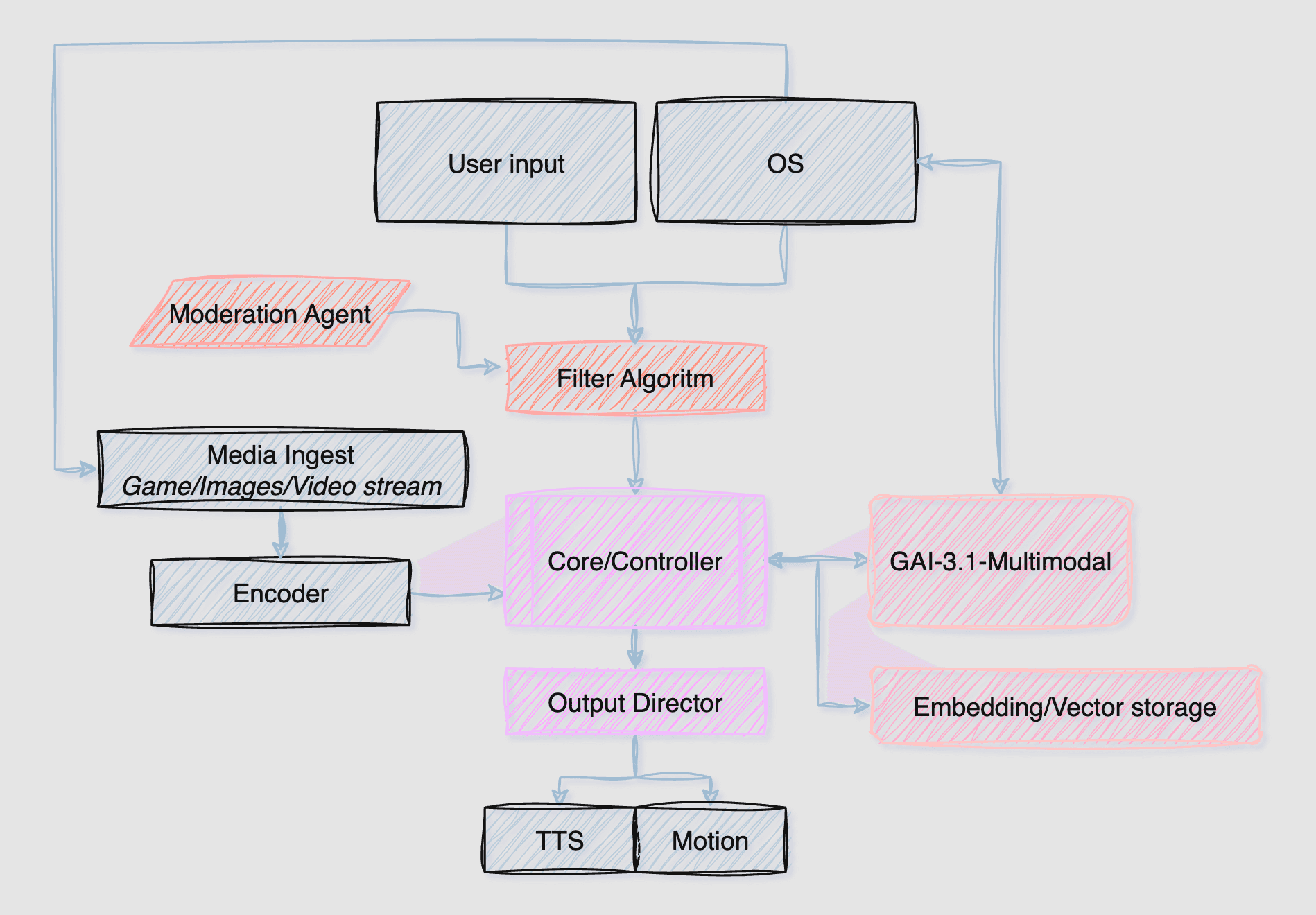

LLM multimodale custom, orchestrazione real-time e controllo hardware completo.

GiuliaAI V3.1

Pipeline multimodale su misura

Il LLM custom gestisce chat, vision, controlli vocali e automazione del desktop. Ogni input passa da un Mod Agent che filtra rumorosità e flagga i comandi critici, prima di essere fuso con il contesto raccolto dagli encoder video e dal database vettoriale.

Core Controller

Orchestra input chat, segnali OS e automazioni. Mantiene la coerenza del personaggio e sceglie quali agent eseguire.

Vision & Context Engine

Encoder multimodale che trasforma stream video, gameplay e desktop in contesto semantico per il LLM.

Output Director

Smista azioni verso TTS, motion capture, avatar controller e macro su Windows tramite API proprietarie in C++.

Stack fisico e runtime

Tutto gira su infrastruttura proprietaria: niente instanze condivise, nessuna dipendenza da software consumer. Il cluster è ottimizzato per stream 24/7 e per l auto fine-tuning senza downtime.

GPU Cluster

4-6× NVIDIA A10G

Profilo bilanciato per inferenza multimodale e fine-tuning on-prem con scheduling interno.

Server dedicati

3 nodi

Controller, Engine e Vector DB isolati per ridurre la latenza tra i moduli.

SDK proprietario

C++ / C# / Python

Layer basso livello per Windows, orchestrazione agent e strumenti di training.

Linguaggi che guidano l SDK

C++ governa il controllo profondo sull hardware Windows e tutta la pipeline AI, C# alimenta gli strumenti di regia live, mentre Python entra in campo solo per il training e il fine-tuning del modello.

C++

40%Driver low-level, pipeline AI e API Windows

C#

35%Tooling realtime e orchestrazione UI

Python

25%Training/fine-tuning del LLM e data tooling

LLM multimodale proprietario

Addestrato su oltre 10 TB di dataset base e rifinito con transcript delle live, GiuliaAI V3.1 comprende italiano colloquiale, slang di Twitch e dinamiche di community. Le sessioni di self fine-tuning avvengono ogni notte usando gli insight raccolti durante il giorno.

Il modello decide quali specialist agent attivare (vision, game, computer controller) e mantiene un tono coerente grazie al retrieval dal Vector DB dedicato.

10 TB+ di dataset di base, vision e comportamento.

Fine-tuning continuo con log dalle live curate manualmente.

Server vettoriale dedicato per memoria breve e storica con retrieval multi-slot.

Controlli di sicurezza su input/mod agent prima che raggiungano il LLM.

Controllo totale su Windows

Per interagire con giochi e applicazioni desktop non bastano macro preconfezionate. Il team ha scritto API di basso livello che parlano direttamente con il sistema operativo, consentendo a GiuliaAI di aprire software, muoversi tra finestre, lanciare bot e sincronizzarsi con OBS o DAW professionali.

API in C++ per simulare input, leggere finestre e interrogare direttamente il kernel Windows.

Driver firmati per accedere alle periferiche (camera, audio, controller) senza software di terze parti.

Profilatura della latenza per ogni macro o azione di gioco, così il LLM sceglie sempre il percorso più rapido.

Misura ciò che conta

Consulta i benchmark di GiuliaAI contro altri LLM leader e scopri come performa in scenari live.

Vai ai benchmark